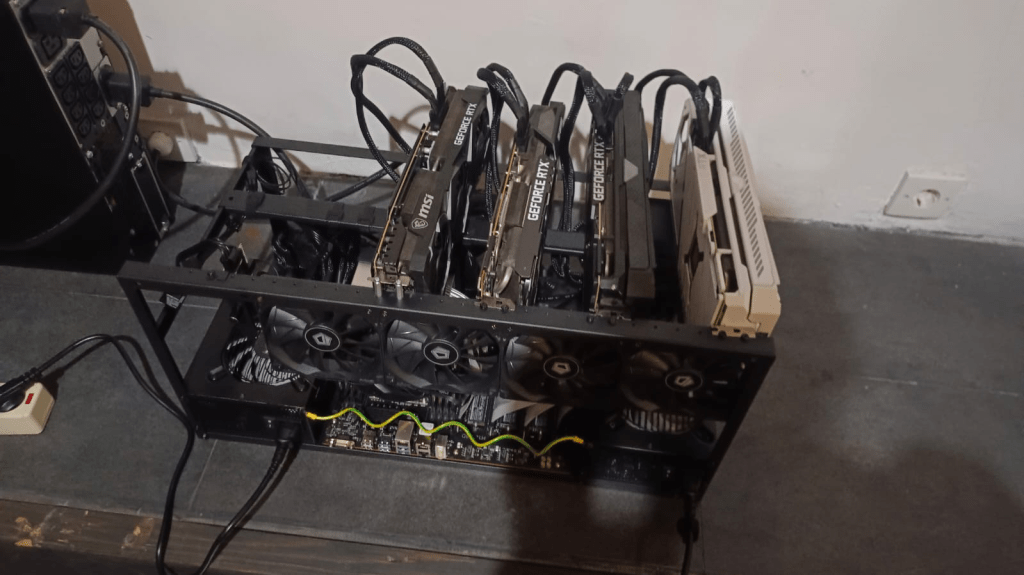

Pagi ini tiba server dengan spesifikasi HPE ProLiant DL380 Gen10 dengan BIOS/ROM U30 v2.90 (07/20/2023), RAM 64 GB, prosesor 2 × Intel Xeon Gold 5218, serta storage 1 × 2.2 TB. Namun tipenya adalah rig, yaitu komputer rakitan khusus dengan frame terbuka yang dirancang untuk komputasi intensif dan memudahkan pemasangan banyak GPU, dengan 4 buah GPU tipe RTX.

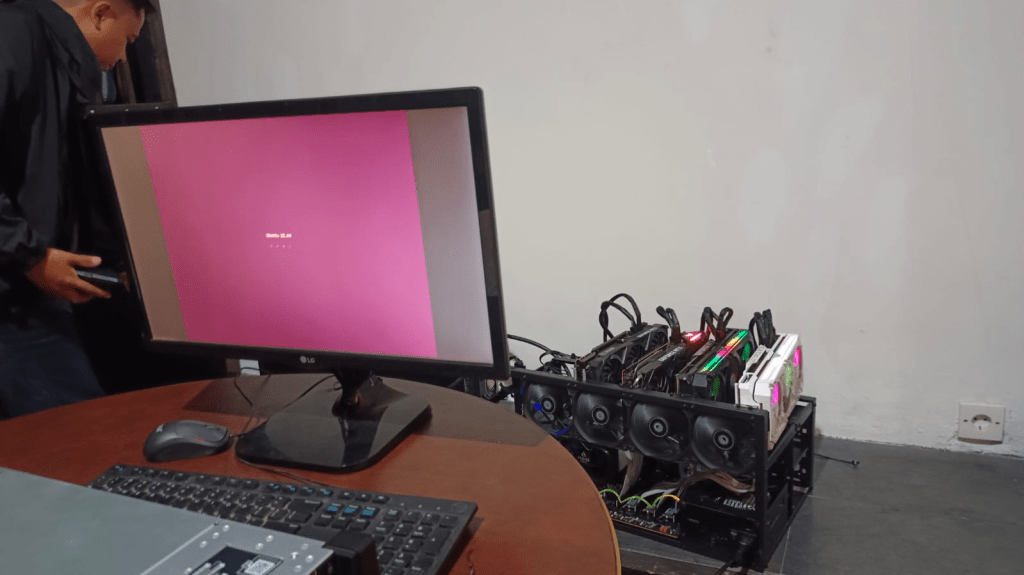

Di dalamnya sudah terpasang Ubuntu Server 22.04 yang dapat menyala, tetapi password tidak dipegang sehingga belum bisa dilakukan pengujian lebih lanjut. Agak unik, tipe rig dengan GPU seperti ini biasanya digunakan untuk komputasi paralel berintensitas tinggi seperti mining cryptocurrency, rendering grafis, simulasi, atau pelatihan model AI/deep learning karena membutuhkan banyak unit pemrosesan secara bersamaan.

Namun di SOCS Universitas Nusa Putra perangkat ini digunakan untuk keperluan Deep Learning, bukan untuk mining crypto. Agak bingung pada awalnya, dimulai dari pemasangan UPS yang cukup berat. Terdapat dua Power Supply Unit (PSU), di sisi kanan dan kiri. Hal yang unik adalah mencari tombol start yang berbentuk seperti kabel kecil memanjang dengan ujung berupa tombol yang ditekan untuk proses booting. Selain itu, masih perlu belajar lagi dalam melakukan pengaturan jaringan (network) pada server melalui terminal.