Profiling terkadang diperlukan ketika ingin mengetahui informasi seseorang misalnya calon pegawai, caleg, dan sebagainya. Mula-mula dilakukan secara manual lewat searching di media sosial. Namun ketika teknologi kian berkembang, banyak aplikasi-aplikasi tersedia untuk membantu proses profiling, salah satunya nucoll dan Gephi.

Nucoll

Nucoll merupakan aplikasi versi baru dari Tweecoll yang banyak dikeluhkan karena tidak mudah berjalan di Windows. Nucoll dapat diunduh programnya di link resminya berikut ini (sesuaikan dengan sistem operasi Anda). Aplikasi ini hanya berisi EXE saja dan dijalankan menggunakan konsol Python.

Untuk menghasilkan file yang akan dilihat network-nya diperlukan tiga langkah sesuai dengan instruksi pada gambar di atas:

-

nucoll init <akuntwitter>

-

nucoll fetch <akuntwitter>

-

nucoll edgelist <akuntwitter>

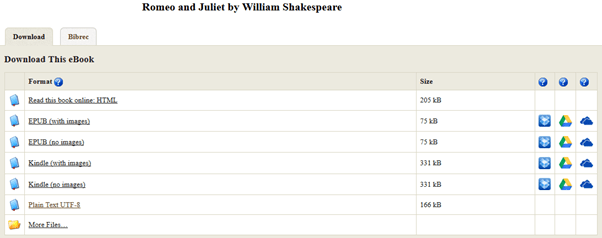

Terdapat file berekstensi dat, gml, dan qry (jika menggunakan fungsi tweets). Hasil yang akan dikirim ke Gephi adalah file berekstensi GML di folder kerja. Berikutnya perlu menginstall Gephi. Sebagai informasi, jika akun twitter yang akan dicari memiliki banyak follower, dibutuhkan proses yang lumayan lama.

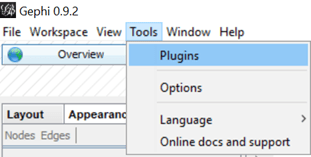

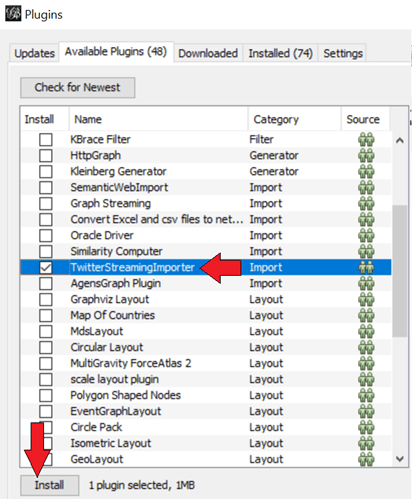

Gephi

Gephi sering digunakan untuk mendeteksi network pengguna twitter. Aplikasi ini dapat diunduh di link berikut. Banyak yang sudah menerapkan, salah satunya adalah drone emprit.

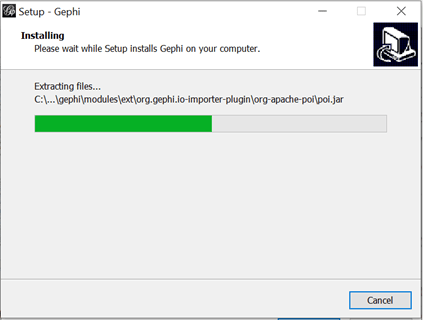

Ketika tulisan ini dibuat, sudah masuk versi 0.9.2. Aplikasi Gephi dibuat dengan menggunakan bahasa Java.

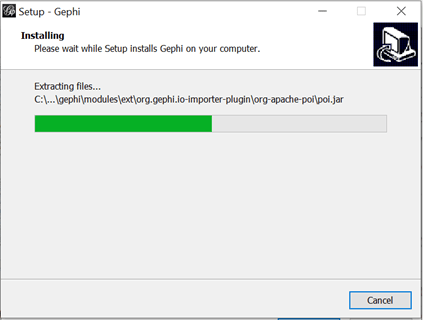

Ikuti saja instruksinya hingga proses selesai. Tunggu beberapa saat hingga selesai.

Berikutnya jalankan Gephi untuk menampilkan network yang berasal dari Nucoll. Buat satu project baru. Impor file GML dari nucoll lewat menu file – open.

Ketika file GML hasil scrapping dengan nucoll diimpor, akan muncul network di Gephi. Tekan simbol “T” di bagian bawah untuk melihat labelnya.

Silahkan yang tertarik bisa melihat tutorialnya di link berikut ini. Banyak fasilitas-fasilitas lain (pewarnaan, indikator-indikator dan sebagainya). Oiya, silahkan gunakan fugnsi “tweets” dari Nucoll untuk men-scrap tweets seseorang. Selamat mencoba, semoga bermanfaat.

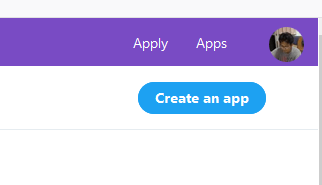

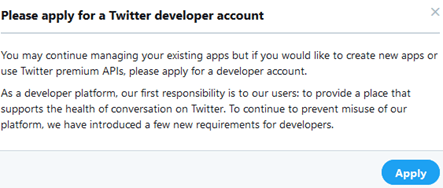

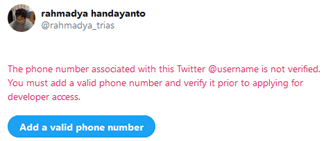

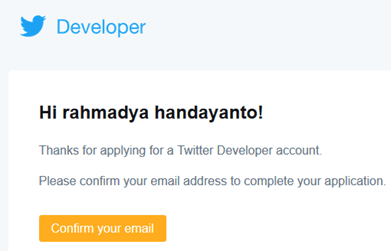

NOTE: Untuk menjalankan Nucoll perlu mendaftarkan Consumer Key (lihat post terdahulu).