Beberapa film menunjukan dampak positif dan negatif dari penggunaan AI di dunia. Dari film ‘AI’ dengan tokoh utamanya robot anak, robocop robot polisi, hingga yang membahayakan seperti David dalam film “Prometheus” (diberi kemampuan berkehendak, akhirnya merusak satu planet, hingga berambisi menjadi tuhan).

Banyak yang mengkhawatirkan masuknya AI tanpa adanya batasan. Mungkin karena bisa dimanfaatkan untuk kejahatan, atau bisa merugikan di kemudian hari walau saat ini mungkin belum terasa dampaknya. Salah satu AI yang cukup mengganggu misalnya engine pada catur (www.lichess.org atau www.chess.com), membuat wasit membutuhkan alat bantu apakah seseorang menggunakan engine atau tidak, hingga perlu AI juga untuk mendeteksi pemain menggunakan engine atau tidak.

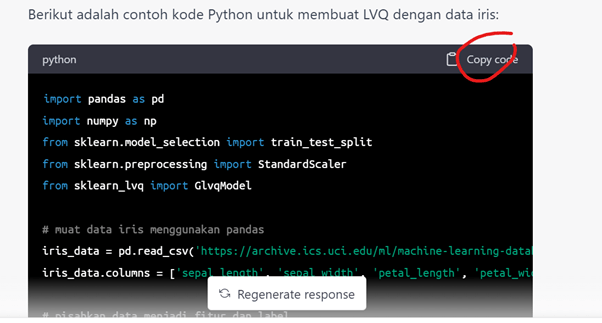

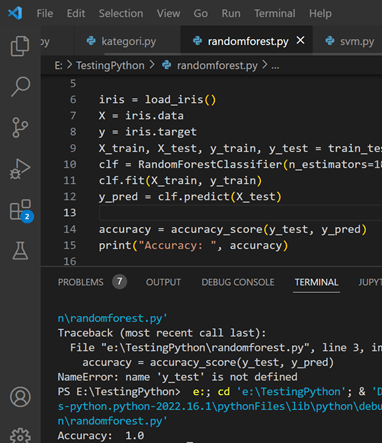

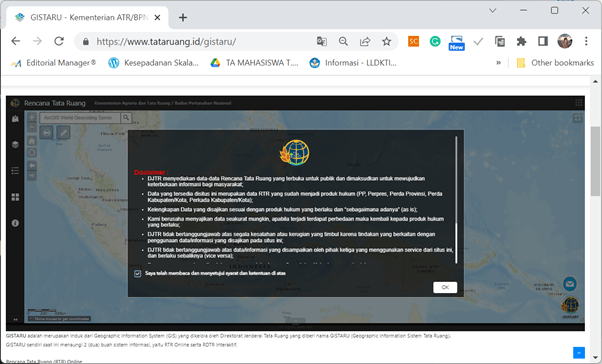

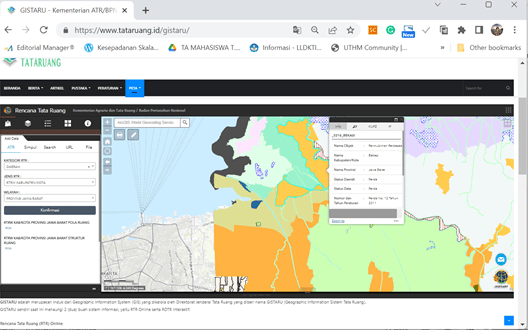

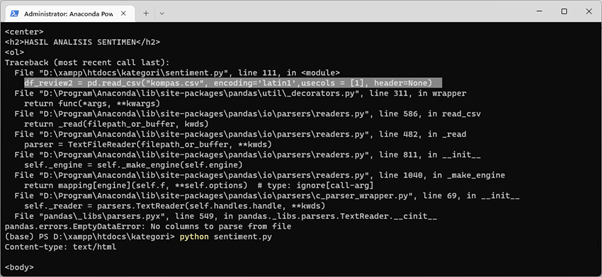

Yang saat ini heboh adalah chatgpt (https://chat.openai.com/chat) dengan kemampuan seperti google tapi mampu berkomunikasi layaknya manusia. Beberapa waktu yang lalu saya memiliki masalah (vektorisasi data NLP dengan TF-IDF yang keluarannya tidak sesuai dengan jumlah record). Dengan google saya perlu mencari kasus-kasus yang mirip, dan mentok ke problem-problem yang sering terjadi saja.

Uniknya ketika masih mentok, belum ada jawaban yang fix, dia bertanya “bisa mengirim sample kode?”. Nah ketika saya paste potongan kode ke chatgpt, makhluk buatan ini langsung menjelaskan detil disertai revisi kodenya dimana [‘text_column’] harus ditambahkan, tidak hanya transform(db_df).

Bahkan Scopus sendiri memasukan ChatGPT sebagai Co-Author artikel ilmiah. Hal ini menyamakan level AI layaknya Co-Author saat ini (manusia). Kita tunggu saja apakah ChatGPT bisa sebagai First Author, dari merancang riset, menulis, submit dan lain-lain.

Aplikasi ini juga mengancam pengajar (guru dan dosen) dalam proses pembelajaran, terutama dalam tugas dan ujian. Mesin-mesin plagiasi perlu mencari cara apakah suatu tulisan dibuat manusia ataukah engine AI. Di Perancis, aplikasi ini dianggap ‘high risk’ dan diband (Link).

Bagaimana jika seorang teroris membuat ChatGPT palsu kemudian secara diam-diam chat dengan anak-anak muda dan melakukan doktrinasi ke remaja-remaja yang masih labil yang tanpa sadar si remaja itu chat dengan manusia yang menyamar sebagai engine dan mengajarkan hal-hal berbahaya.

Selama idola, fans, role model masih manusia, entah itu atlit, artis, guru dan dosen, keberadaan kita masih dibutuhkan. Guru dan dosen pun jadi sadar bahwa tidak hanya transfer ilmu dan skill saja yang diiperoleh dari institusi pendidikan melainkan akhlak, teladan yang baik, hingga bertambahnya network/jaringan/circle. Sekian, semoga bisa menginspirasi.