Buku berbeda dengan artikel jurnal dari sisi konten. Jika jurnal merupakan hasil penelitian terkini, buku sedikit tertinggal beberapa tahun. Namun biasanya buku lebih stabil keilmuwannya, alias sudah “established”. Biasanya buku digunakan sebagai sumber referensi untuk kasus tertentu karena formatnya yang rapi, tidak terlepas ke sana-sini seperti artikel ilmiah. Toh, jurnal pun sesungguhnya terbit setelah penelitian yang dilakukan beberapa tahun belakangan, jadi tidak baru-baru amat. Postingan ini sedikit memberi gambaran bagaimana membuat buku dengan mudah dan cepat.

Materi Kuliah

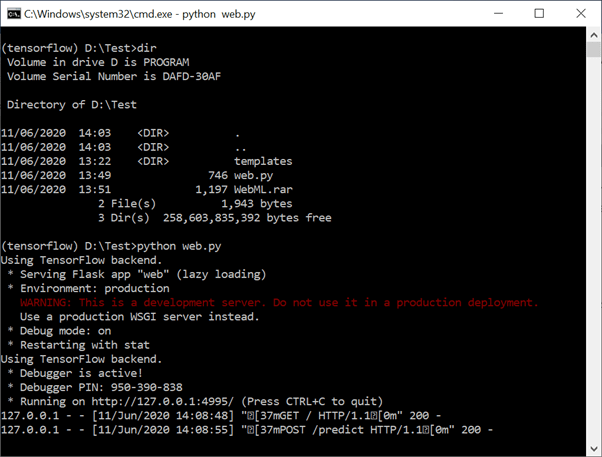

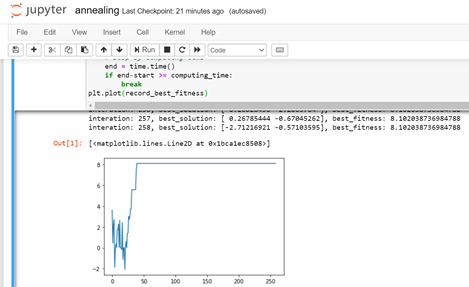

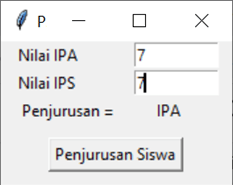

Waktu itu diminta ngajar mata kuliah “Data Mining” di kampus besar yang terletak di Pondok Kopi. Total ada 14 pertemuan. Kebetulan perkuliahan disertai dengan praktek di laboratorium. Dalam satu kali pertemuan saya buat satu bab, jadi total setelah perkuliahan selesai, jadilah buku sekitar 14 bab. Jadi ketika mengajari, langsung saja “capture” langkah-langkahnya. Tidak perlu ditulis dulu karena menulis membutuhkan waktu. Toh, dari hasil capture kita tahu apa yang harus ditulis nanti. Lihat postingan saya 7 tahun yang lalu tentang teknik ini.

Di akhir semester ada waktu kira-kira sebulan untuk membuat kata-kata yang mengalir. Ada sisi positifnya jika kita menulis materi kuliah. Ketika mempraktekan terkadang dapat diketahui apakah modul berjalan dengan baik. Terkadang ada saja hal-hal yang dijumpai siswa yang membuat praktik tidak berjalan. Hal ini penting untuk ditulis karena pembaca buku adalah pembelajar mandiri yang harus jelas dari “a” sampai “z” tanpa ada guru/tutor. Jika tidak berjalan, tentu saja mengecewakan pembaca. Namun toh, biasanya ada saja masalah dijumpai dan pembaca mengirim pertanyaan lewat email, terutama masalah kompatibilitas dengan laptopnya. Tapi biasanya berjalan dengan baik oleh pembaca. Kalaupun hanya memanfaatkan dari “help” tetap harus dicoba oleh penulis apakah bisa berjalan dengan baik atau perlu alat bantu lain. Beberapa penulis buku tidak menganjurkan memanfaatkan “help” karena untuk apa buat buku kalau di “help”-nya sudah ada.

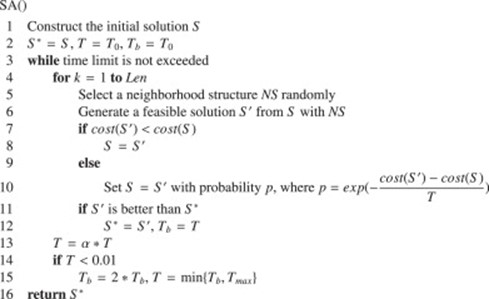

Hasil Penelitian

Nah, yang ini agak sulit. Beberapa penerbit menolak membukukan hasil penelitian (skripsi, tesis, atau disertasi). Hal ini saya dengar langsung oleh perwakilan penerbit (waktu itu dari Andi offset) yang diundang oleh pihak kampus saya waktu itu (STMIK Nusa Mandiri). Saya lupa tahunnya, yang jelas waktu itu masih “ST”. Oiya, mungkin dosen-dosen muda sekarang heran melihat S1 yang menjadi dosen. Pasti lebih heran lagi kalau tahu jabatan fungsional Lektor saya diperoleh waktu masih bergelar S1 (lektor 200). Waktu itu memang jamannya orang enggan jadi dosen, sehingga kebutuhan dosen masih tinggi. Nah, si penerbit bersedia membukukan hasil penelitian jika mampu mengemas laporan penelitiannya dalam bentuk sudut pandang “orang awam”. Maksudnya pembaca harus dijejali hal-hal yang perlu agar mereka bisa mengikuti. Ini yang membuat penulis harus kerja ekstra mengetik ulang hasil penelitiannya. Nah nanti di akreditasi terbaru dengan format 9 standar, tiap dosen harus memasukan hasil penelitiannya ke materi ajar. Jadi buku yang dibuat kombinasi dari materi kuliah dengan hasil penelitian. Agak repot juga ketika mengajar mata kuliah yang berbeda dengan roadmap penelitiannya, jadi tidak bisa disisipi hasil penelitian. Jadi intinya, penerbit ingin pembaca tidak membutuhkan sumber-sumber lain untuk memahami, artinya dengan satu buku itu sudah paham. Kalau memerlukan buku lainnya, biasanya pembaca kerepotan karena harus merogoh kocek lagi untuk beli buku lainnya.

Menolong Orang Lain

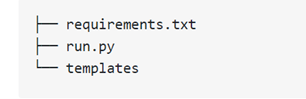

Siapa yang ditolong? Banyak, misalnya kampus (lewat poin akreditasi karena ada buku), dosen (karena ada materi kuliah), industri/developer (untuk membuat software/aplikasi), dan mahasiswa (untuk kuliah dan tugas akhir/skripsi). Hal ini terjadi karena buku berbeda dengan artikel ilmiah yang terkadang merahasiakan kode sumber, sementara buku selain menyertakan kode sumber, terkadang diberikan CD/DVD atau file yang dishare di internet (dari website, Github, dan lain-lain). Kebanyakan mereka seumur hidup hanya sekali merasakan skripsi/tugas akhir, jadi tidak mungkin melupakan buku yang ia baca ketika berpusing-pusing ria dalam merampungkan kuliahnya. Saya pun sampai sekarang masih ingat buku-buku yang membantu saya lulus kuliah. Terakhir, tentu saja membantu penerbit. Mereka secara jujur kesulitan mencari penulis buku, padahal jumlah penulis potensial di tanah air harusnya di atas negara lain.

Revisi Atau Baru?

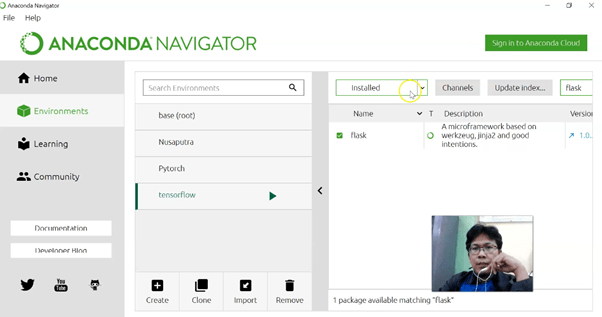

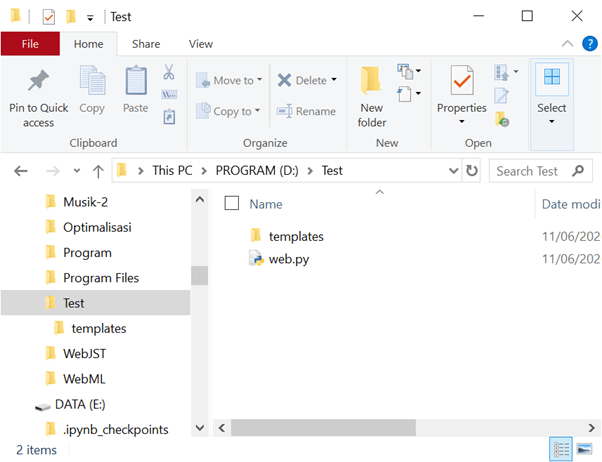

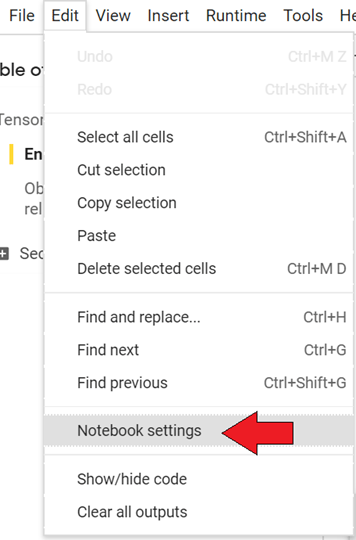

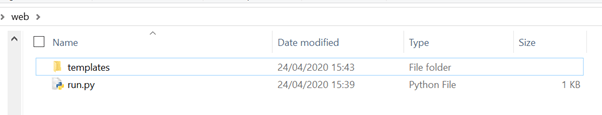

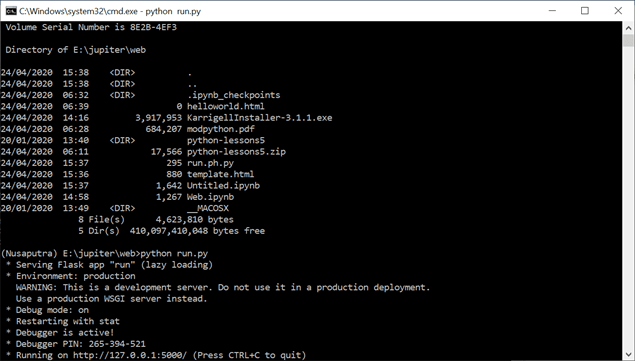

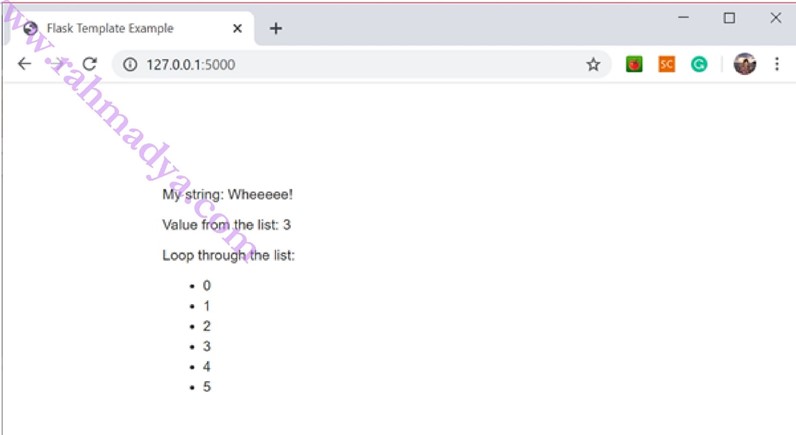

Sebenarnya saya ingin merevisi buku yang dulu, tetap mengingat isi yang jauh berbeda, terpaksa membuat versi yang benar-benar baru. Salah satu hal yang membedakan adalah “web-based machine learning“. Silahkan cari di internet buku tentang machine learning atau data mining berbasis web, masih jarang. Hal ini terjadi karena antara front-end (web developer) dengan back-end (data scientis) berasal dari orang dengan fokus yang berbeda. Perlu ada jembatan yang menghubungkan keduanya. Pengguna pun lebih nyaman menggunakan apikasi data mining dengan GUI berbasis web yang mudah diakses dari manapun. Jadi dengan tambahan web-based machine learning mudah-mudahan dapat menjembatani front-end dan back-end. Penggunaan bahasa Python pun karena trend bahasa pemrograman ini yang terus naik (lihat pos yang lalu) sampai-sampai Google mengadopsi bahasa ini dalam pemrograman onlinenya (lihat pos yg lalu tentang Google Colab).

Sebagai bonus, penulis terkadang harus cuek, apalagi menulis buku. Jika novel atau cerpen, kita bisa menggunakan nama samaran jika kita tidak ingin repot dengan para kritikus. Beberapa pakar di tanah air terkadang merendahkan tulisan dari penulis-penulis lokal dan cenderung menganjurkan buku-buku internasional yang “wah”. Tidak apa-apa kalau punya pandangan seperti itu, toh niat kami membantu anak-anak yang mungkin kurang skill bahasa Inggrisnya dengan bahasa yang mudah mereka mengerti. Jika dikatakan tulisan “instan” ya tidak apa-apa, kan repot juga mahasiswa dipaksa belajar bahasa Inggris dulu baru bisa lulus. Prinsip saya dan penulis-penulis lokal lainnya sebenarnya sederhana, membantu memberikan pemahaman kepada masyarakat umum, tidak merahasiakan ilmu atau menyarankan mereka mengikuti kursus yang harganya terkadang tidak terjangkau oleh mahasiswa-mahasiswa rata-rata di tanah air yang untuk bayar kuliah saja sulit. Tentu saja kalau mampu silahkan buat buku bertaraf internasional yang “wah” dan itu bagus banget menurut saya. Semoga berminat menulis buku.

Update: 10 April 2021

Buku sudah avaiable di toko-toko buku dan online shop, semoga bermanfaat.

Update: 1 Januari 2025

Tidak terasa sudah 4 tahun vakum menulis. Coba buat buku lagi mengingat teknologi saat ini berkembang sangat cepat. Masih dengan tema yang sama, tapi dengan implementasi khusus yang sangat dibutuhkan oleh mahasiswa, terutama level S1 dan S2.